基于Wikipedia的本体学习研究

第一章绪论1第一章绪论§1.1研究背景及意义万维网已经成为人们获取信息的主要渠道之一,深刻影响到人类社会生活的各个方面:人们在Web上浏览新闻、搜索信息、买卖商品及服务。然而,当人们每天在享受万维网带来的便利时,却也日渐发现想要快速、准确地从Web中获取自己需要的信息似乎变得越来越困难了。其中的主要原因在于目前的万维网是面向人而不是面向机器的。换句话说,Web内容主要是提供给人来理解和浏览的,而计算机“看到的”Web内容只是二进制数据,对其内容无法进行识别。这使得计算机不能向人类那样自动理解网页内容中的语义信息,无法实现Web内容的自动处理。另外,Web是按URL而非内容来定位信息资源的,因此...

相关推荐

-

【拔高测试】沪教版数学五年级下册期末总复习(含答案)VIP免费

2024-11-19 20

2024-11-19 20 -

【基础卷】小学数学五年级下册期末小升初试卷四(沪教版,含答案)VIP免费

2024-11-19 10

2024-11-19 10 -

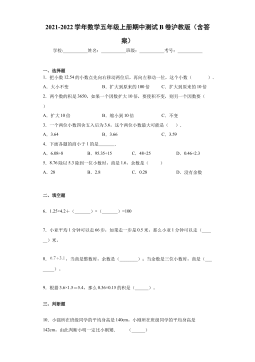

期中测试B卷(试题)-2021-2022学年数学五年级上册沪教版(含答案)VIP免费

2024-11-19 12

2024-11-19 12 -

期中测试B卷(试题)- 2021-2022学年数学五年级上册 沪教版(含答案)VIP免费

2024-11-19 18

2024-11-19 18 -

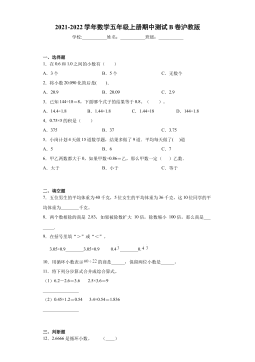

期中测试A卷(试题)-2021-2022学年数学五年级上册沪教版(含答案)VIP免费

2024-11-19 19

2024-11-19 19 -

期中测试A卷(试题)-2021-2022学年数学五年级上册 沪教版(含答案)VIP免费

2024-11-19 26

2024-11-19 26 -

期中测B试卷(试题)-2021-2022学年数学五年级上册 沪教版(含答案)VIP免费

2024-11-19 25

2024-11-19 25 -

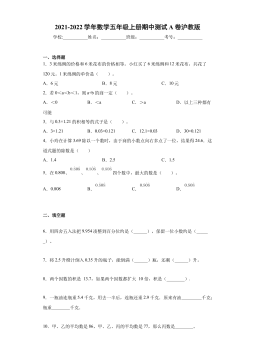

期中测A试卷(试题)-2021-2022学年数学五年级上册沪教版(含答案)VIP免费

2024-11-19 32

2024-11-19 32 -

【七大类型简便计算狂刷题】四下数学+答案

2025-03-18 16

2025-03-18 16 -

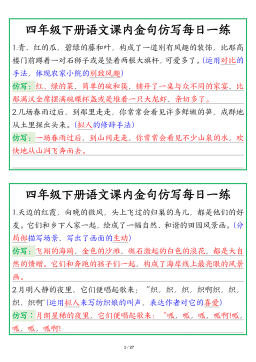

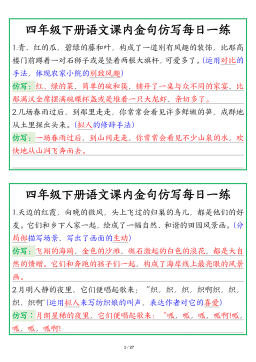

【课内金句仿写每日一练】四下语文

2025-03-18 43

2025-03-18 43

相关内容

-

期中测试A卷(试题)-2021-2022学年数学五年级上册 沪教版(含答案)

分类:中小学教育资料

时间:2024-11-19

标签:无

格式:DOCX

价格:5 积分

-

期中测B试卷(试题)-2021-2022学年数学五年级上册 沪教版(含答案)

分类:中小学教育资料

时间:2024-11-19

标签:无

格式:DOCX

价格:5 积分

-

期中测A试卷(试题)-2021-2022学年数学五年级上册沪教版(含答案)

分类:中小学教育资料

时间:2024-11-19

标签:无

格式:DOCX

价格:5 积分

-

【七大类型简便计算狂刷题】四下数学+答案

分类:中小学教育资料

时间:2025-03-18

标签:数学计算;校内数学

格式:PDF

价格:1 积分

-

【课内金句仿写每日一练】四下语文

分类:中小学教育资料

时间:2025-03-18

标签:无

格式:PDF

价格:1 积分